影象合成是計算機視覺中的一個重要問題。谷歌大腦的Ian Goodfellow等人在他們的最新研究中提出“自注意力生成對抗網路”(SAGAN),將自注意力機制引入到卷積GAN中,作為卷積的補充,在ImageNet多類別影象合成任務中取得了最優的結果。

論文地址:

https://

arxiv。org/pdf/1805。0831

8。pdf

影象合成(Image synthesis)是計算機視覺中的一個重要問題。隨著生成對抗網路(GAN)的出現,這個方向取得了顯著進展。基於深度卷積網路的GAN尤其成功。但是,透過仔細檢查這些模型生成的樣本,可以觀察到,在ImageNet這類的有許多影象類別的資料集上訓練時,卷積GAN合成的影象不盡如人意。

針對這個問題,谷歌大腦的Ian Goodfellow和Augustus Odena,以及羅格斯大學的Han Zhang和Dimitris Metaxas等人在他們的最新研究中提出“自注意力生成對抗網路”(SAGAN),將自注意力機制(self-attention mechanism)引入到卷積GAN中,作為卷積的補充,取得了最優的結果。

摘要

在這篇論文中,我們提出自注意力生成對抗網路( Self-Attention Generative Adversarial Network ,SAGAN)。SAGAN允許對影象生成任務進行注意力驅動、長相關性的建模。傳統的卷積GAN生成的高解析度細節僅作為在低解析度特徵圖上的空間區域性點的函式。在SAGAN中,可以使用來自所有特徵位置的線索來生成細節。此外,鑑別器可以檢查影象的遠端部分的高度詳細的特徵彼此一致。此外,最近的研究表明,生成器條件會影響GAN的效能。利用這些發現,我們將譜歸一化到GAN生成器中,並發現這改進了訓練動態。我們提出的SAGAN達到了state-of-the-art的結果,將Inception score從當前最高的36。8提高到52。52,並且在具有挑戰性的ImageNet資料集上將Frechet Inception distance從27。62降低到18。65。注意力層的視覺化表明,生成器利用與物件形狀相對應的鄰域,而不是固定形狀的區域性區域。

SAGAN:將自注意力機制引入GAN

儘管最先進的ImageNet GAN模型 [17] 擅長合成幾乎沒有結構性限制的影象類別(例如,海洋、天空和景觀類,它們的區別更多在於紋理而不是幾何結構),但它無法捕獲在某些類別中經常出現的幾何模式或結構模式(例如,狗通常有逼真的皮毛紋理,但沒有明確區分的腳)。

一種可能的解釋是,以前的模型嚴重依賴於卷積來建模不同影象區域之間的依賴關係。由於卷積運算子具有一個區域性感受域,所以在經過幾個卷積層之後,只能處理長距離的相關性。

由於各種原因,這可能會阻止學習長相關性(long-term dependencies):小的模型可能無法表示它們,最佳化演算法可能無法發現引數值,這些引數值仔細協調多個層,以捕獲這些相關性,並且這些引數化在統計學上可能相當脆弱,當應用於以前未見過的輸入時容易失敗。增加捲積核的大小可以提高網路的表徵能力,但這樣做也會失去利用區域性卷積結構獲得的計算和統計效率。

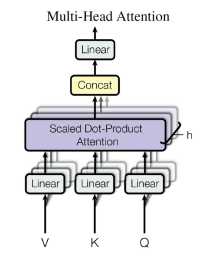

另一方面,自注意力(Self-attention)可以更好地平衡模型的長相關性和計算與統計效率。self-attention模組以所有位置的特徵加權和來計算響應,其中權重(或attention vectors)只以很小的計算成本來計算。

圖 1:我們提出的SAGAN透過利用影象遠端部分的互補特徵來生成影象,而不是固定形狀的區域性區域,從而可以生成一致的物件/場景。圖中每一行的第一個影象顯示了帶顏色編碼點的五個代表性查詢位置。其他五個影象是針對這些查詢位置的 attention maps,其中對應的顏色編碼的箭頭概括了最受關注的區域。

在這項工作中,我們提出了自注意力生成對抗網路(SAGAN),它將自注意力機制(self-attention mechanism)引入到卷積GAN中。自注意力模組(self-attention module)是對卷積的補充,有助於模擬跨越影象區域的長距離、多層的依賴關係。透過self-attention,生成器可以繪製圖像,所繪製圖像中每個位置的精細細節都與影象遠端的精細細節充分協調。此外,鑑別器還可以更準確地對全域性影象結構執行復雜的幾何約束。

圖2:所提出的self-attention機制。⊗表示矩陣乘法,在每一行上執行softmax操作

除了self-attention之外,我們還將最近關於網路調節(network conditioning)的見解與GAN的效能結合起來。A。 Odena等人的研究[18]表明,調節良好的生成器往往表現更好。我們建議使用以前僅應用於鑑別器的譜歸一化技術(spectral normalization)來加強GAN生成器器的調節。

我們在ImageNet資料集上進行了大量的實驗,以驗證所提出的self-attention機制和穩定技術的有效性。SAGAN在影象合成方面的表現遠遠超過了state-of-the-art的表現,將此前報告的最高Inception score從36。8提高到52。52,將Fréchet初始距離(Fréchet Inception distance,FID)從27。62降低到18。65。attention層的視覺化顯示,生成器利用與物件形狀相對應的區域,而不是固定形狀的區域性區域。

ImageNet上的影象合成實驗

為了評價所提出的方法,我們在LSVRC 2012 (ImageNet)上資料集進行了大量的實驗。首先,我們對評估所提出的兩種穩定GAN訓練的技術進行有效性實驗。其次,對所提出的self-attention mechanism進行了研究。最後,將SAGAN與其他state-of-the-art的影象生成方法進行了比較。

評估指標

我們使用Inception score(IS)和Fréchet初始距離(FID)進行定量評估。Inception score越高,表示影象質量越好。 FID是一個更加基於規則和綜合性的指標,並且在評估生成的樣本的真實性和變異性方面已被證明與人類的評估更加一致。越低的FID值意味著合成數據分佈與真實資料分佈之間的距離更近。

圖3:基線模型與我們的模型的訓練曲線,利用了我們提出的穩定技術

表1:GAN的Self-Attention與Residual塊的比較。這些塊被新增到網路的不同層。所有模型都經過100萬次迭代的訓練,並報告最佳的Inception score(IS)和Fréchet初始距離(FID)

圖4:基線模型和我們的模型隨機生成的128×128影象樣本

圖5:attention maps的視覺化。這些影象都由SAGAN生成

與state-of-the-art模型的比較

在ImageNet上,SAGAN與最先進的GAN模型[19,17]進行了比較。如表2所示,我們提出的SAGAN得到了Inception score和FID。Inception score方面,SAGAN將此前0最高的36。8提高到52。52;FID(18。65)也表明,SAGAN可以透過使用self-attention模組對影象區域之間的全域性依賴關係進行建模,從而更好地模擬原始影象的分佈。圖6展示了由SAGAN生成的一些示例影象。

表2: 將所提出的SAGAN與最先進GAN模型進行比較,任務是ImageNet上的類別條件影象生成

圖6:SAGAN 生成的不同類別的128×128解析度示例影象。每行展示一個類別的示例

總結

在本研究中,我們提出自注意力生成對抗網路(SAGAN),它將self-attention機制引入到GAN的框架。 self-attention 模組在建模長相關性( long-range dependencies)方面很有效。另外,我們證明了應用於生成器的譜歸一化可以穩定GAN的訓練,並且TTUR加速了正則化鑑別器的訓練。SAGAN在ImageNet的分類條件影象生成任務上達到最先進的效能。

(本文首發於新智元微信公眾號:AI_era,歡迎關注!)